En la implementación se ha considerado realizar un programa generalizado, de manera que se pueda aplicar a diferentes casos, para esto las entradas son patrones, que contienen un vector característico y un valor deseado de salida, el factor de aprendizaje y el valor mínimo de error.

Como criterio de parada se considero que el error de época sea menor que un valor determinado (0.1).

En la fase de entrenamiento se consideró los siguientes patrones

1 0 0 1 1

1 0 1 0 2

1 0 1 1 3

1 1 0 1 5

Factor de aprendizaje = 0.3

Valor de error mínimo = 0.1

Se probó con estos datos el programa y el aprendizaje nos dio como resultados lo siguiente:

Número de Iteraciones = 49

w = 0.6350 3.7432 1.6340 0.5798

Ahora para probar que el aprendizaje fue correcto se probó con las siguientes nuevas entradas:

>> convertidor(w,[1,1,1,1])

rpta = 7

>> convertidor(w,[1,1,0,0])

rpta = 4

>> convertidor(w,[1,1,1,0])

rpta = 6

Como podemos notar los resultados son los deseados y por lo tanto queda demostrado que el aprendizaje fue correcto.

Notas:

El factor de aprendizaje mas adecuado que se encontró es el 0.3 porque por ejemplo si probamos con el factor 0.5 el aprendizaje no es tan bueno, como podemos notar a continuación:

Número de Iteraciones = 45

w = 0.1335 4.3759 1.8665 0.7593

>>convertidor(w,[1,1,0,1])

rpta sin redondeo=5.2687

rpta = 5

>> convertidor(w,[1,1,0,0])

rpta sin redondeo=4.5094

rpta = 5

Como se puede notar el resultado de la segunda conversión no es correcta, por tanto el factor

de aprendizaje 0.5 no es el adecuado.

Si el factor de aprendizaje es 0.1 se tiene lo siguiente:

Número de Iteraciones = 265

w = 0.2678 4.2013 1.8016 0.8055

>> convertidor(w,[1,1,0,0])

rpta = 4

>> convertidor(w,[1,1,0,1])

rpta = 5

>> convertidor(w,[1,1,1,1])

rpta = 7

>> convertidor(w,[1,1,1,0])

rpta = 6

>> convertidor(w,[1,0,1,1])

rpta = 3

>> convertidor(w,[1,0,1,0])

rpta = 2

>> convertidor(w,[1,0,0,1])

rpta = 1

>> convertidor(w,[1,0,0,0])

rpta = 0

Como podemos notar el aprendizaje es correcto pero el número de iteraciones son muchas.

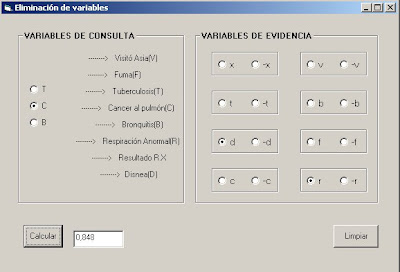

como podemos ver en la imágen anterior la noticia pertenece a la clase "deporte" con una probabilidad de 0.64

como podemos ver en la imágen anterior la noticia pertenece a la clase "deporte" con una probabilidad de 0.64